Capire il futuro algoritmico dell’intelligenza aliena autonoma, dove i sensori e la tecnologia sono ovunque

Pubblichiamo in collaborazione con Luca Sossella editore una serie di estratti da Collassi, una collana di testi dedicati alle rivoluzioni tecnologiche che si traducono in sistemi sociali e nel precipitato inconsapevole della vita quotidiana. Oggi un estratto dal saggio di Mario Pireddu, Algoritmi. Il software culturale che regge le nostre vite.

Il futuro sarà sempre più caratterizzato dal ruolo centrale degli algoritmi, e se non vogliamo essere semplicemente usati dai software dobbiamo capire come funzionano e come produrne di migliori. Esistono già milioni di software e di algoritmi che agiscono nel mondo, e spesso lo fanno perché sono capaci non solo di analizzare ma anche di sentire il mondo esterno.

Le Google Car che si guidano da sole negli Stati Uniti attraverso i loro sensori vengono già considerate per legge dei guidatori a tutti gli effetti, e le implicazioni filosofiche e etiche della guida automatizzata sono al centro di dibattiti e dispute che vanno avanti da anni.

La capacità di agire nel mondo è definita agency, e ai software ormai sono riconosciuti gradi di agentività rilevanti: è ormai generalmente accettata l’idea di agentività distribuita tra esseri umani e cose, e c’è chi si spinge a sostenere che sia impossibile distinguere la tecnologia dalla cultura e la tecnologia dall’umano.

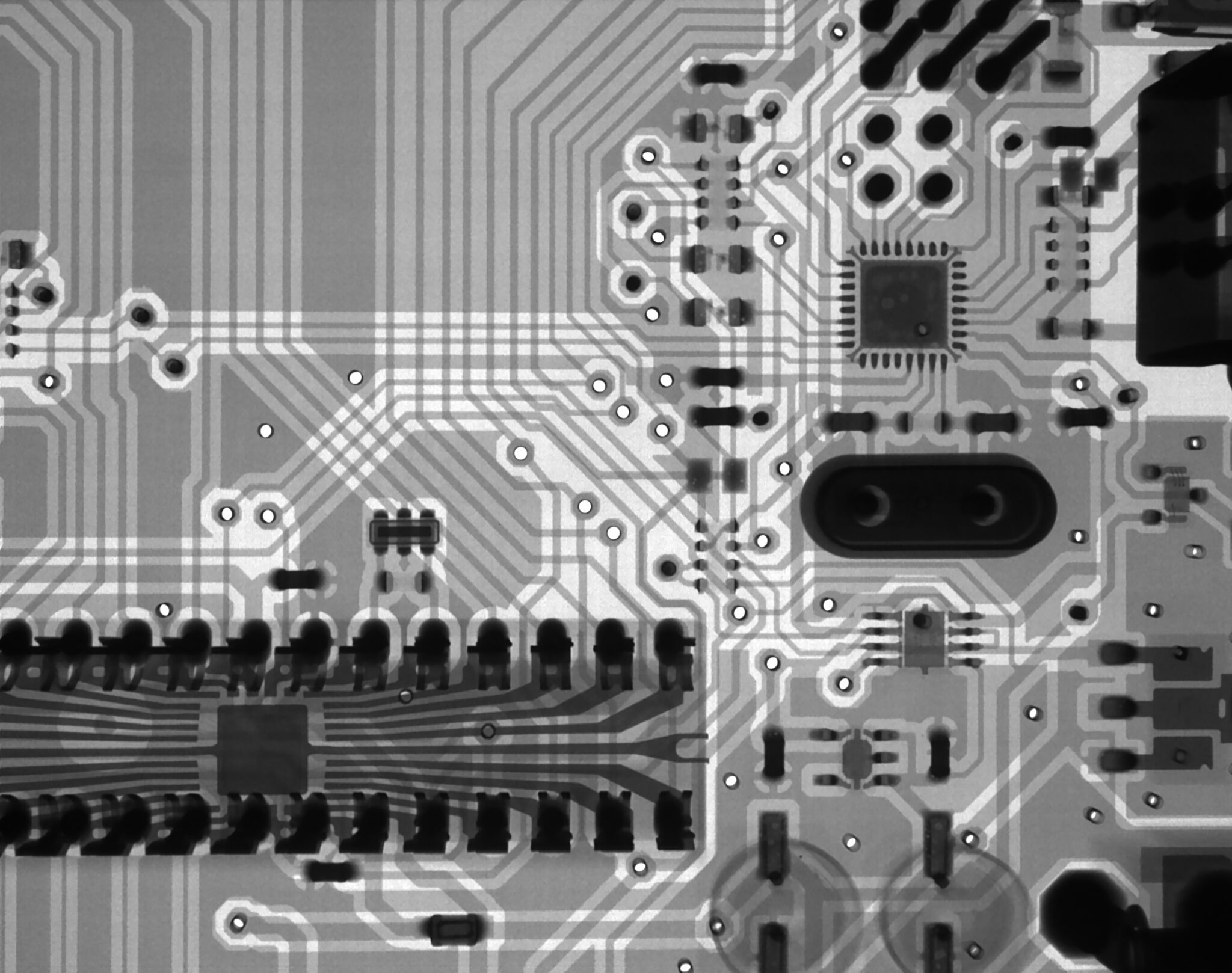

Una cosa è comunque chiara: nonostante l’idea diffusa di software e algoritmi come entità immateriali o senza corpo, il codice è sempre radicato nella materia.

Segni, impulsi, catalizzatori per cambi di stato fisici, sensori ecc.: il software ha una sua realtà materiale complessa e articolata, è distribuito e incorporato in varie infrastrutture sociotecniche.

I dati e i sensori che disseminiamo nel mondo contribuiscono a ridisegnare il nostro stesso concetto di ambiente. Le punte più avanzate degli studi sugli ecosistemi mostrano l’utilizzo mirato di tecnologie di sensing che si fondono con l’ambiente per garantire un monitoraggio ambientale impossibile per i soli umani.

Nonostante l’idea diffusa di algoritmi come entità immateriali o senza corpo, il codice è sempre radicato nella materia

Si parla da tempo di produzione di sensorialità e di esperienza a prescindere dalla presenza e dall’attività umana diretta: se ciò può apparire audace, si pensi alla sonda Cassini e al suo lungo viaggio verso Saturno, o a quanto fatto da Mars Lander su Marte.

In realtà gli esempi di sensorialità non umana applicata all’elaborazione algoritmica sono ormai ovunque e mostrano una complessità sempre crescente.

Quel che non va dimenticato è che gli algoritmi sono spesso progettati per apprendere: elaborano temporalmente generalizzazioni sequenziali imparando gradualmente dall’esperienza per preparare ulteriori azioni future.

Si tratta di processi che nelle loro declinazioni più sorprendenti hanno portato a risultati come quello di AlphaGo Zero, l’intelligenza artificiale creata da Google Deep Mind che in soli tre giorni ha imparato da sola a giocare a Go – antico gioco da tavolo cinese tra i più complessi al mondo in termini di tattica e strategia – e in pochissimo tempo è diventata il giocatore più forte nella storia millenaria del gioco strategico.

È il caso di ripeterlo: non siamo davanti a Terminator o Matrix, ma l’esistenza di queste entità comincia ad avere un impatto forte per la nostra cultura, ed è il caso di sforzarci di comprendere meglio queste trasformazioni.

Gli algoritmi di machine learning apprendono dai dati e dall’esperienza, e spesso in maniera non prevedibile e conoscibile. Se quindi gli algoritmi non sono più semplici istruzioni che devono essere eseguite ma entità performanti che valutano, selezionano, trasformano e producono dati e nuova conoscenza, abbiamo davanti un cambio di paradigma radicale.

Cosimo Accoto, studioso di digital analytics e big data e filosofo di formazione, sottolinea la necessità di un’accountability e di un auditing degli algoritmi: in altri termini, di una conoscenza responsabile, condivisa e più trasparente.

L’apprendimento automatico per via algoritmica è già al centro di molte attività che svolgiamo come lavoratori, consumatori e cittadini, e si occupa di implementare macchine che migliorano con l’esperienza.

Il machine learning consiste in un insieme di metodi utili a estrarre schemi e pattern dai dati in maniera automatica, per poter prendere decisioni in situazioni di incertezza e avere un più forte potere predittivo.

Il machine learning consiste in un insieme di metodi utili a estrarre schemi e pattern dai dati in maniera automatica

Creando e ricombinando algoritmi, abbiamo utilizzato i risultati e i dati prodotti dalle loro elaborazioni per creare altri algoritmi.

E quando abbiamo iniziato a creare algoritmi automatici di apprendimento abbiamo dato vita a algoritmi che creano altri algoritmi, delegando a queste entità il compito della creazione.

La direzione sembra quella dell’automatizzazione dell’automazione, e c’è già chi parla di “intelligenza aliena autonoma”.

È indubbio che il software sia diventato negli ultimi decenni l’infrastruttura che regge la nostra economia attuale, la nostra produzione di cultura e il suo consumo, le nostre relazioni sociali: è il motore spesso invisibile delle nostre società, che detta le condizioni di possibilità del nostro mondo.

“Il software prende il comando”, scrive Manovich: ricopre oggi la stessa importanza che avevano l’elettricità e il motore a scoppio nel secolo scorso, ed è la nostra interfaccia con il mondo, con gli altri, con la nostra memoria e i prodotti della nostra immaginazione.

È un vero e proprio software culturale, perché viene utilizzato da miliardi di persone e gestisce “atomi di cultura”, contenuti mediali, informazioni e relazioni.

Consente di creare e accedere a oggetti e ambienti mediali. È ciò che rende possibile tutte le dimensioni del vivere sociale su cui si sono concentrate – quasi sempre senza considerarlo strategico – tutte le teorie sociali degli ultimi decenni.

Informazione, reticolarità e conoscenza dipendono dal software, eppure per molti resta ancora invisibile o poco comprensibile.

È indispensabile comprendere il ruolo del software e degli algoritmi nella formazione della cultura contemporanea, e ancora più indispensabile è comprendere le logiche e le forze economiche, sociali e culturali che ne stanno plasmando lo sviluppo.

Il rischio, in caso contrario, è quello di considerare unicamente i suoi effetti e mai le sue cause, o in altre parole i risultati che vediamo sugli schermi e non i programmi e la cultura che lo producono e gli danno forma.

Nel suo libro WTF: What’s the Future and Why It’s Up to Us, Tim O’Reilly – fondatore del gruppo O’Reilly Media e da sempre attento studioso delle evoluzioni del web – parla di alcuni “algoritmi fuori controllo” votati unicamente alla massimizzazione dei profitti di chi li ha creati.

Lo fa per sottolineare la necessità di una riflessione aggiornata e di azioni specifiche per riequilibrare un settore per ora ancora troppo poco compreso e studiato al di fuori dei settori specialistici.

Kate Crawford, ricercatrice per Microsoft e cofondatrice di AI Now, sostiene che i cittadini devono sapere come funzionano i sistemi che prendono decisioni e come questi siano stati testati o convalidati.

Tali sistemi diventeranno tanto più complessi quanto più le tecnologie come l’apprendimento automatico utilizzate dalle aziende tecnologiche diventano più ampiamente disponibili.

La ricercatrice afferma che può essere possibile rendere pubbliche alcune informazioni sui sistemi e il loro funzionamento senza necessariamente divulgare il loro codice (spesso tutelato come proprietà intellettuale).

Non solo le aziende come Netflix, YouTube o Facebook, ma anche molti governi si affidano sempre più ad algoritmi e software per prendere decisioni e decidere le proprie priorità d’intervento.

Ci sono esempi di algoritmi che hanno aiutato il raggiungimento di maggiore equità, ma ci sono anche casi di algoritmi che incorporano pregiudizi e parzialità.

Il software è l’infrastruttura che regge l’economia, la produzione di cultura e le nostre relazioni social

ProPublica, un ente no-profit che si occupa di giornalismo investigativo, nel 2016 ha denunciato un sistema di classificazione utilizzato negli Stati Uniti per la gestione di condanne e cauzioni in diversi stati perché viziato da pregiudizi contro gli afroamericani.

Il problema degli algoritmi “polarizzati” o che incorporano storture e visioni pregiudiziali era emerso ufficialmente anche grazie a uno degli ultimi lasciti dell’amministrazione Obama, una relazione sui modi in cui l’Intelligenza Artificiale trasformerà l’economia degli Stati Uniti dei prossimi anni e decenni.

In quel documento, pubblicato alla fine del 2016, il gruppo di lavoro ha scritto esplicitamente che “i responsabili delle politiche dovranno affrontare nuove barriere potenziali derivanti da qualsiasi polarizzazione algoritmica”.

Negli ultimi anni, soprattutto nei paesi anglosassoni, continua ad aumentare il numero di cittadini e di associazioni che lottano per accedere alle informazioni sugli algoritmi che hanno influenza sulle nostre vite.

Si chiede alle aziende di verificare che strumenti e processi del machine learning operino con dati non tendenziosi; si chiede più ricerca e politiche volte a garantire l’utilizzo di sistemi automatizzati di assunzione non discriminanti nei confronti di specifici individui o gruppi.

Già da tempo, infatti, alcune grandi società come Goldman Sachs e Unilever utilizzano tecnologie (definite “più obiettive degli esseri umani”) che analizzano le espressioni facciali e la voce di chi si candida per un lavoro, allo scopo di assistere chi si occupa delle assunzioni.

Tecnologie come queste, per gli analisti che seguono l’evoluzione di questi fenomeni, dovrebbero essere soggette a rigorosi esami che prevedano la pubblicazione dei risultati.

Anche nei paesi in cui la sensibilità verso gli algoritmi utilizzati dai governi per modellare la vita dei cittadini sta crescendo, si tratta comunque di processi lenti: la maggior parte delle città e degli stati non dispone delle competenze necessarie per progettare i propri sistemi, o per analizzare e comprendere correttamente quelli pro- dotti da soggetti privati o esterni.

E allora in chiusura possiamo chiederci: perché non educare le persone a una maggiore consapevolezza in termini di logica culturale dei database, metadati e algoritmi?

Non si tratta di formare nuovi informatici o ingegneri dell’informazione, ma di fornire strumenti di base per poter essere cittadini e consumatori più consapevoli.

La maggior parte delle città non dispone delle competenze necessarie per progettare i propri sistemi

In molti paesi si lavora sull’introduzione di percorsi di studio e utilizzo attivo dei media all’interno dei cicli di istruzione scolastica e universitaria, allo scopo di raggiungere una media literacy di base.

La stessa Commissione Europea ha messo al lavoro dei gruppi di ricerca sulle competenze digitali, che hanno prodotto il framework europeo DigComp, aggiornato periodicamente e dedicato all’individuazione delle competenze chiave da promuovere, consolidare, validare e certificare.

Dalla primavera del 2017 il framework si è arricchito di una versione dedicata al settore educativo denominata DigCompEdu, la cui prima bozza si sta imponendo in ambito europeo come riferimento per l’implementazione di linee guida nazionali e per la progettazione di percorsi formativi che tengano conto dei mutamenti sociali, economici, culturali e antropologici degli ultimi anni.

Il testo che accompagna la proposta iniziale del DigCompEdu fa riferimento all’ubiquità dei dispositivi digitali e al dovere di aiutare gli studenti a diventare utenti digitali consapevoli, con un richiamo esplicito alla necessità di avere insegnanti e formatori in grado di sviluppare la propria competenza digitale.

Riconoscere di far parte di un mondo che cambia velocemente – e che per molti versi è già radicalmente cambiato – dovrebbe essere il punto di partenza per riflettere sul senso delle istituzioni educative nella società. Gli insegnanti non vivono fuori dal mondo che si regge sull’infrastruttura di rete, e lo stesso vale per gli studenti.

Come abbiamo visto, quel mondo agisce e incide quotidianamente su ciò che si fa e su come lo si fa: perché dunque la scuola dovrebbe rendere impermeabili le proprie pareti, invece di aprirsi a quel mondo lasciandosi penetrare ed entrandovi pienamente?

Le indicazioni europee forniscono un indirizzo e lavorano su una strada per certi versi già aperta. Resta da capire se saremo all’altezza dei sistemi complessi che abbiamo creato. Curiosamente, in nessuno dei documenti prodotti dai gruppi di lavoro europei compare la parola algoritmo.